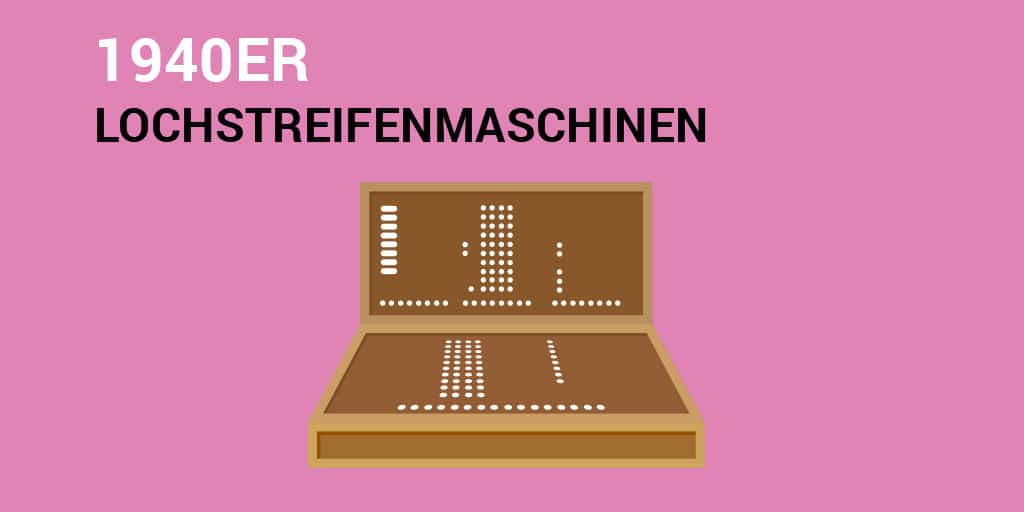

Es ist gar nicht so leicht, die Geschichte des Computers mit ihren wichtigsten Stadien nachzuvollziehen. Trotzdem versuchen wir es. Komprimiert findet ihr den Überblick ab den 40er Jahren in der Bildgalerie etwas weiter unten.

Wer sich für die Zukunft interessiert, springt gleich unter die Galerie. Künstliche Intelligenz, Neurotransmitter und Quantencomputing sind Aspekte, die man weiter verfolgen sollte.

Analoge Rechenmaschinen

Zu Beginn am Besten erstmal eine Begriffsklärung: Der Begriff „Computer“ kommt vom lateinischen Wort „computare“. Das bedeutet „berechnen“ oder zusammenrechnen“.

Es gab in der gesamten Menschheitsgeschichte schon immer analoge Rechenmaschinen, die auf verschiedene Zahlensysteme angewandt wurden: den Abakus, das Rechenbrett des Pythagoras, das Räderwerk von Antikythera. Im MIttelalter war „Computer“ eine Berufsbezeichnung für Menschen, die komplizierte Kalkulationen vornahmen, zum Beispiel für Astronomen.

Mechanische Rechenmaschinen

Zu Beginn des 17. Jahrhunderts wurden die ersten mechanischen Rechner erfunden. Dazu zählen die Logarithmentafel von John Napier (1614), die Pascaline von Blaise Pascal (1642) und die Vierspezies-Maschinen von Wilhelm Schickard (1632) und von Gottfried Wilhelm Leibniz (1673). Letzterer ersann das binäre Zahlensystem, das die Grundlage der ersten Digitalrechner bildete.

Das Mooresche Gesetz (engl. Moore’s Law) besagt, dass sich die Anzahl der Transistoren auf einem Computerchip alle 18 – 24 Monate verdoppelt. Das heißt, dass sich die Leistung von Computerchips alle zwei Jahre verdoppelt.

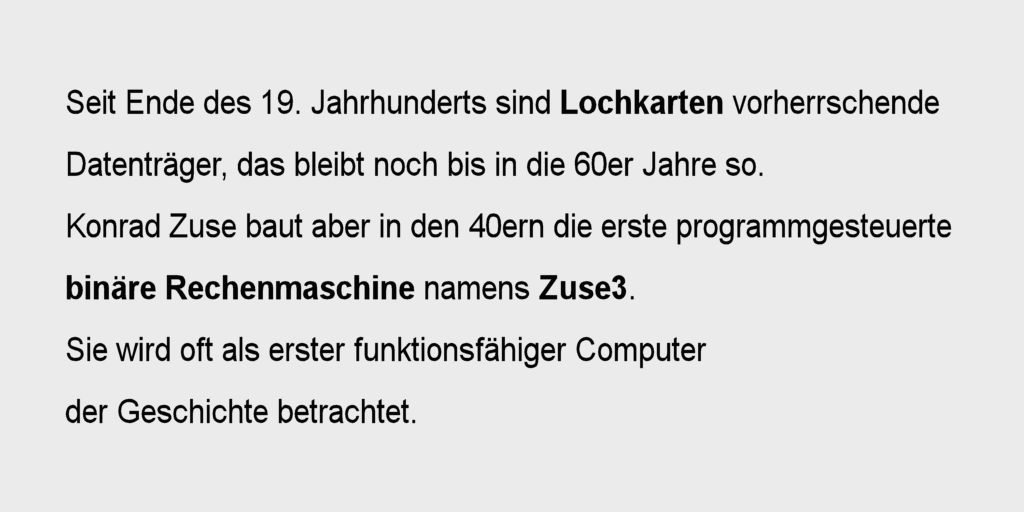

Digitale Rechenmaschinen

Heute versteht man unter einem „Computer“ eine digitale Rechenmaschine, die mithilfe von Programmen, also Software, Daten verarbeitet. Die ersten elektronischen Rechner aus den 40er Jahren waren noch so groß wie Schränke – heute passen Computer in jede Hosentasche. Ja, die Smartphones sind gemeint. Sie sind schon lange keine Telefone mehr, sondern hochleistungsfähige Mini-Computer im Handtaschenformat.

Künstliche Intelligenz – quo vadis?

Es ist schwer abzuschätzen, wie „der Computer“ der Zukunft aussehen wird. Der immer neugierige Mensch experimentiert. Bevorzugt nach der vor Jahrhunderten aufgestellten wissenschaftlichen Maxime „Trial and Error“ – Versuch und Irrtum.

So sagte zum Beispiel Ryan Adams, Informatik-Professor und Gründer eines an Twitter verkauften Start-ups für Maschinenlernen, noch im Jahr 2016 über das Deep Learning von künstlicher Intelligenz (Erklärungen zu Begriffen siehe unten bei MEHR INPUT): „Diese Deep-Learning-Systeme machen coole Sachen. Wir verstehen sie kaum, aber sie funktionieren“.

Aufruf zu differenzierter Folgenabschätzung

Die Rechenprozesse der Algorithmen von künstlicher Intelligenz (KI) sind auch vier Jahre später noch zu schnell und zu differenziert, um sie im Detail nachzuvollziehen. Schlagzeilen wie „Steven Hawking warnt vor KI als schlimmstem Ereignis der Zivilisationsgeschichte“ oder „Elon Musk fürchtet, KI könne die Kontrolle über uns übernehmen“ schüren eine unangemessene Besorgnis.

Beide Männer äußern sich – beziehungsweise äußerten, denn Stephen Hawking verstarb im März 2018 – sehr differenziert dazu, warum sie solche Behauptungen aufstellen. Sie „prophezeien“ gar nichts, sondern formulieren sehr bedacht mit „könnte“. Und plädieren für eine kontrollierte Herangehensweise an diese neue Technologie unter Beachtung ethischer Vorgaben. Bitte unbedingt die unter MEHR INPUT verlinkten Artikel lesen.

Neurotransistoren

Jetzt gerade im Juli 2020 brachte der Bigdata Insider einen Artikel heraus, der die jüngsten Forschungsergebnisse der TU Dresden und des Helmholtz-Zentrums Dresden-Rossendorf (HZDR) thematisiert. In einem Projekt wurden Neurotransistsoren entwickelt, die die Arbeitsweise des menschlichen Gehirns nachahmen.

Würde man Roboter mit solchen Transistoren ausstatten, könnten diese Zusammenhänge erkennen und viele menschliche Funktionen nachahmen, ohne dass man sie programmieren müsste – so lautet es zumindest von Seiten der Wissenschaftler.

Quantencomputer

Super kompliziert! Derzeit benutzte digitale Computer sind immer auf Rechenprozesse angewiesen, die sich zwischen zwei Gegensätzen entscheiden: Null oder Eins. Um es zu veranschaulichen: Man fährt mit dem Auto los und entscheidet sich an jeder Kreuzung, ob man nach rechts oder links fährt. Immer wieder.

Quantencomputer können mehr: Für sie gibt es keine Entweder-Oder-Entscheidung. Sie können im Prinzip zur gleichen Zeit die Wege nach rechts, nach links, nach geradeaus und sogar nach oben oder unten berechnen. Und sie müssen nicht sofort entscheiden.

Übertragen auf unser Beispiel: Das Auto steht / schwebt an der Kreuzung und man hat als Fahrer sehr viel Zeit, um zu überlegen, wohin man nun fahren möchte – rein theoretisch könnte man sogar rückwärts, in einer Spirale oder eigentlich in jede beliebige Richtung fahren / fliegen. Das ist das Prinzip des Gedankenexperimentes Schrödingers Katze.

Das Prinzip von Schrödingers Katze, erklärt von Harald Lesch (Astrophysiker und Wissenschaftsjournalist)

Wie geht es weiter?

An dieser Stelle müssen wir den Artikel quasi unterbrechen. Zum einen ist der ohnehin schon viel zu lang geworden! Wer liest denn soviel Text im Netz? Zum anderen ist gerade die Ausgabe 4 / 2020 des Print-Magazins Datareport erschienen. Und was denken Sie, was wir da drin haben? Genau: Eine Infografik, die das Quantencomputing allgemeinverständlich erklärt. (Seite 8 im PDF, Seiten 14 / 15 im Printheft). Letzeres kann man übrigens kostenlos einmalig bestellen oder dauerhaft abonnieren.

(Text: Andrea Brücken)

Mehr Input

- Unterschied zwischen Deep Learning und Machine Learning

Erklärartikel auf datasolut.com - Machine Learning – Infografik

Wie es funktioniert - Computer nach dem Vorbild des Gehirns

Bigdata Insider über die Entwicklung von Neurotransistoren - KI anstelle von Transistoren?

derstandard.at - Historischer Computer im Keller gefunden

Golem.de

![:data[re]port](https://datareport.online/wp-content/uploads/2018/08/datareport-logo.png)